La course aux meilleurs modèles d'intelligence artificielle s'est transformée en une guerre de chiffres. Pour mesurer la performance des IA, les chercheurs leur font passer des tests, aussi appelés benchmarks, avec à la clé des pourcentages de réussite. Ces indicateurs servent ensuite aux ingénieurs à prouver la supériorité de leurs modèles sur ceux de leurs concurrents, dans l'objectif d'attirer utilisateurs et investisseurs. Mais un problème de taille se dessine à court terme : les benchmarks les plus utilisés depuis le début de la vague ChatGPT, fin 2022, commencent à être dépassés par les performances des dernières générations de modèles. Au point qu'une véritable crise de l'évaluation se profile pour le secteur.

Entreprise incontournable de l'écosystème, Hugging Face a décidé de prendre les devants en proposant depuis fin juin de tout nouveaux tests, afin de créer une grille d'évaluation capable d'accueillir les IA de demain. La startup franco-américaine a ainsi mis à jour son classement de performance des modèles open source - les IA dont les développeurs acceptent de partager une partie de leur recette de création - qui pourrait rapidement servir d'inspiration au monde des modèles propriétaires comme ceux de OpenAI, Anthropic, ou Google.

Saturation et contamination

Les benchmarks actuels se confrontent à deux grands difficultés. Pour commencer, les chercheurs pointent leur « saturation » : les modèles d'IA dernier cri tendent de plus en plus vers les 100% de réussite aux tests, avec des scores supérieurs à 80%, voire 90%. Si la trajectoire d'amélioration se poursuit, les modèles de demain devraient réussir à la perfection les évaluations d'aujourd'hui, et les benchmarks ainsi « saturés » ne permettraient plus de les départager. Autrement dit, le secteur à besoin de redimensionner sa grille d'évaluation des modèles avec de nouveaux benchmarks, plus difficiles.

Le second problème évoqué par les chercheurs s'appelle la « contamination ». Il concerne d'autant plus les benchmarks les plus anciens, ayant beaucoup circulé en ligne. Concrètement, certaines IA ont appris directement ou indirectement (par le biais de forums de discussion, par exemple), volontairement ou non, les réponses aux questions des tests. En cause, les ingénieurs entraînent leurs IA sur des volumes colossaux de données, dont ils ne communiquent pas le détail, qu'ils ne connaissent d'ailleurs pas le plus souvent.

Il devient alors difficile de déterminer si le modèle a été exposé aux résultats des benchmarks pendant ce gavage de données. Dans ces cas de « contamination », le modèle passe son examen avec l'appui d'une antisèche (plus ou moins bien écrite) et non sur ses simples capacités, ce qui gonfle artificiellement le score final et fausse les comparaisons...

Des tests plus exigeants et mieux ciblés

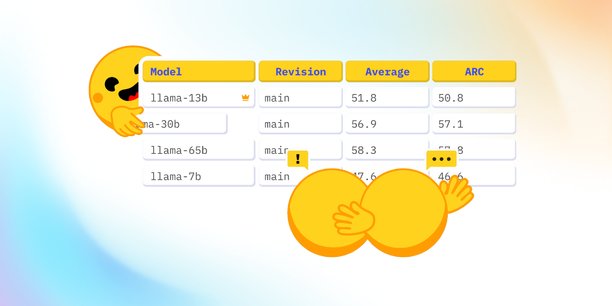

Ces deux problèmes sont au centre des travaux de Clémentine Fourrier et Nathan Habib, chercheurs spécialistes de l'évaluation chez HuggingFace. L'an dernier, la startup franco-américaine a lancé sous leur responsabilité l'Open LLM Leaderboard, un classement de performance des meilleurs modèles d'IA open source.

« On avait observé que la sortie de chaque nouveau LLM [grand modèle de langage, ndlr] s'accompagnait d'une publication de benchmarks, mais qu'il était très difficile de reproduire les résultats avancés par les chercheurs. C'est pourquoi nous avons proposé notre classement, avec une méthodologie transparente, afin de présenter des scores vérifiables par n'importe qui », raconte Clémentine Fourrier.

Avec sa volonté de s'affirmer comme « la plateforme centrale et agnostique de l'IA open source », Hugging Face avait le profil parfait pour endosser le rôle d'arbitre dans la course à la performance. Rapidement, le secteur a validé sa démarche : la page accueille plus de 300.000 visiteurs par mois d'après l'entreprise, et le score produit pour le classement fait référence, souvent partagé sous forme de capture d'écran par les ingénieurs eux-mêmes. « De bonnes performances sur le leaderboard peuvent avoir beaucoup d'impact. Pour certaines startups, c'est un déclencheur de financements », fait valoir la chercheuse. D'ailleurs, Hugging Face reçoit en avance les nouveaux modèles stars (comme le récent Llama 3 de Meta), afin de pouvoir publier ses évaluations en même temps que la sortie du modèle.

Pour garder ce positionnement, la startup se devait d'être précurseur dans le renouvellement des benchmarks. C'est ainsi qu'elle en a choisi six nouveaux benchmarks (dont le détail est dans l'article des chercheurs). Objectif : évaluer les facultés de compréhension du modèle, ses facilités à effectuer un raisonnement « complexe », sa capacité à suivre des instructions, ou encore ses performances en mathématiques, physique, chimie et biologie. Le tout, selon une grille d'évaluation plus exigeante. La moyenne des 100 meilleurs modèles hébergés sur Hugging Face au nouveau test d'évaluation des capacités de raisonnement mathématiques des modèles ? Un bien faible 3 sur 100. « Ce benchmark, particulièrement imposant, existait avant les LLMs. Nous n'en avons gardé que les questions les plus dures », précise la chercheuse.

Pour autant, les nouveaux tests n'ont pas pour seul objectif de rehausser les seuils d'exigences. Ils visent aussi à mieux évaluer les performances des modèles d'IA générative sur des tâches pour lesquelles ils sont réellement utilisés, comme la discussion par chat. « La discussion par chat, comme d'autres tâches, n'était pas un enjeu pour les benchmarks d'IA avant l'arrivée des LLM. Il nous fallait donc trouver de nouveaux moyens d'évaluation », rappelle Clémentine Fourrier.

Une initiative à copier pour OpenAI et consorts ?

La nouvelle grille d'évaluation a bouleversé le top 10 du classement d'Hugging Face. Si l'on retrouve les meilleurs modèles de chacune des deux stars de l'open source - la startup française Mistral et le géant américain Meta - sur le podium, la première place est occupée par Qwen-72B. Ce modèle d'Alibaba Cloud obtient un score moyen de 42,49/100, bien loin des scores à plus de 80/100 de l'ancien classement. Une autre entreprise chinoise encore méconnue, la startup 01.AI, a encore plus profité du changement de l'évaluation, puisque son modèle Yi-1.5 a bondi de plus de 30 places pour se hisser à la sixième position !

Il faut également compter sur la présence de startups prometteuses, comme Cohere et son modèle Command R+. De quoi donner un joli aperçu de la concurrence croissante dans l'IA open source, où se mettent même à participer les géants Google (avec Gemma) et Microsoft (avec Phi, très bien placé malgré sa petite taille), pourtant très investis du côté des modèles propriétaires.

Grâce à sa mise à jour, Hugging Face va pouvoir accueillir dans de bonnes conditions l'accélération à venir de la course à la performance des IA open source. « Cette seconde version du classement résout, du moins temporairement, le problème de la saturation des benchmarks. Quant à la contamination, c'est un sujet de recherche actif, mais plus complexe à résoudre », concèdent les chercheurs d'Hugging Face. Puisqu'ils s'imposent la contrainte de créer des évaluations reproductibles, ils s'obligent à utiliser des benchmarks avec des réponses accessibles à tous, par nature sensibles aux risques de contamination.

Autre conséquence immédiate de cette exigence de transparence : il ne faut pas compter sur la startup pour faire l'arbitre entre les modèles propriétaires comme GPT-4 d'OpenAI, Claude 3 d'Anthropic, ou Gemini 1.5 de Google, largement considérés comme les modèles les plus performants. Ces derniers gardent entièrement secrètes leurs recettes de conceptions, et sont donc les seuls à pouvoir vérifier avec certitude que leurs scores ne sont pas truqués. Ce qui n'empêche pas chaque sortie de modèle de s'accompagner d'un tableau comparatif avec les modèles concurrents sur plusieurs benchmarks. En revanche, même s'ils ne peuvent s'appuyer sur Hugging Face comme tiers de confiance, nul doute qu'OpenAI et consorts regarderont de près les résultats des nouveaux benchmarks proposés par la startup franco-américaine, qui pourraient être utilisés pour démontrer la puissance de la nouvelle génération de modèles attendus à la rentrée.

« Le tourisme en Corse est broyé par les dysfonctionnements » (César Filippi, GHR)

« Le tourisme en Corse est broyé par les dysfonctionnements » (César Filippi, GHR)

Sujets les + commentés