Moshi sait chuchoter, parler comme un pirate, converser sur la randonnée, et même chantonner. Moshi (traduction de allô en japonais) est une intelligence artificielle générative vocale lancée par Kyutai le 3 juillet. Ce laboratoire de recherche français, financé par le fondateur de Free Xavier Niel, le dirigeant de CMA CGM Rodolphe Saadé (propriétaire de La Tribune), et Eric Schmidt, ex-PDG de Google, s'est lancé en novembre dernier. Objectif, attirer la crème des chercheurs grâce à des projets de recherche à la pointe de l'IA générative. Le tout en open source, c'est-à-dire librement accessible.

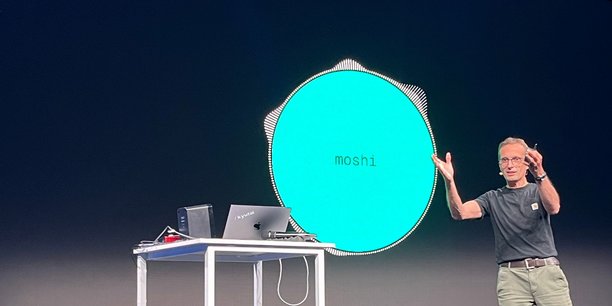

En quelques mois et avec une équipe réduite de 8 chercheurs, un financement conséquent (300 millions d'euros, dont seule une petite partie aurait déjà été dépensée) mais bien moins important que ceux des mastodontes du secteur, on peut reconnaître à Kyutai la prouesse d'avoir mis au point une IA générative vocale fluide, capable de répondre à un interlocuteur très rapidement. « C'était six mois de folie », résume Patrick Pérez, directeur général de Kyutai sur scène, lors d'une conférence organisée à l'Ircam pour présenter les toutes premières avancées du jeune laboratoire.

OpenAI repousse son lancement

Le coup fait d'autant plus mouche qu'OpenAI, leader américain du secteur et père de ChatGPT, a présenté il y a quelques semaines une technologie similaire, ChatGPT-4o Voice, avant de reculer son lancement auprès du grand public. Moshi, elle, peut déjà être expérimentée par quiconque via une interface de démonstration (les conversations ne sont possibles qu'en anglais pour le moment et ne durent pas plus de 5 minutes). Impossible toutefois de lui demander d'analyser une image ou une vidéo, comme il sera possible de le faire avec la version vocale de ChatGPT-4o.

Mais Kyutai assure également travailler sur ces sujets. Sur la fluidité de conversation et la rapidité, difficile de comparer les deux technologies. « Je vous répondrai quand j'aurais testé le système d'OpenAI », lance Patrick Pérez. Par ailleurs, pour le moment ces technologies ne font pas l'objet d'article scientifique qu'il est possible de comparer. Celui des équipes de Kyutai sur Moshi devrait être publié prochainement.

Notons que le lien pour partager la démonstration de Moshi a été diffusé via le compte X (ex-Twitter) du laboratoire. Ce dernier espérait peut-être reproduire l'effet ChatGPT, lancé sans grande fioriture par OpenAI fin 2022 via les réseaux sociaux, avant de provoquer le séisme que l'on connaît.

Une rapidité de réponse jamais égalée, avancent les chercheurs

Lors de sa présentation sur scène, Moshi impressionne par sa rapidité. « La latence est de 160 millisecondes, c'est la plus basse au monde », fait valoir Alexandre Défossez, l'un des chercheurs de l'équipe fondatrice. Kyutai est parvenue à cette prouesse en permettant à son intelligence artificielle de « réfléchir et parler en même temps ». Les modèles classiques d'IA vocale passent normalement par plusieurs étapes qui rendent le temps entre la question posée et la réponse assez long, allant parfois jusqu'à 5 secondes. D'abord, ils détectent une voix, puis transcrivent les paroles en texte. Ensuite, ils passent par un grand modèle de langage pour générer du texte en réponse, qui sera lui-même transformé en voix. Moshi lui est un « audio language model », qui génère des fichiers audios directement en prédisant la suite d'un extrait audio qu'il entend.

La tonalité de la voix de Moshi est naturelle, semblable à ce que démontrait OpenAI sur scène en mai. Mais ici pas de Scarlett Johansson ou simili Scarlett Johansson. C'est une artiste vocale, Alice, qui a prêté sa voix (une vingtaine d'heures d'enregistrement ont été nécessaires) au système. Preuve à l'appui : une courte vidéo d'Alice est diffusée sur scène, comme pour jouer la carte de la transparence face à un OpenAI critiqué pour avoir copié la voix de l'actrice sans son consentement.

Mais l'effet "Her" (film de Spike Jonz, où le personnage principal tombe amoureux de son assistant vocal) que promettait OpenAI n'est pas complètement au rendez-vous. Les fondateurs de Kyutai ne filent d'ailleurs pas la comparaison contrairement à Sam Altman. Moshi est rapide, mais presque trop. Les différents chercheurs de l'équipe du laboratoire qui défilent sur scène pour échanger avec l'IA n'arrivent pas toujours à finir leurs phrases, ou à interrompre Moshi quand elle parle trop longtemps.

Après la présentation, Alexandre Défossez reconnaît que les temps de pause entre les interactions ont sans doute été trop réduits, et qu'il faudra améliorer ce point.

Moshi se répète et coupe un peu trop la parole

Et lorsqu'on teste soi-même l'outil (mis en ligne quelques heures après la démonstration), c'est assez frustrant. Pendant nos essais, impossible de faire chantonner Moshi, ni de la faire chuchoter, ni de lui faire prendre une voix de pirate - ce qu'elle était pourtant capable de faire sur scène. Par ailleurs, Moshi répète parfois la même chose plusieurs fois, ou cesse de répondre sans donner de raison, donnant l'impression de discuter avec une vieille tante un peu dure de la feuille.

Malgré ces couacs techniques, Moshi reste impressionnante sur plusieurs points. D'une part, ce modèle préfigure sans doute la manière dont nous nous adresserons prochainement aux intelligences artificielles. C'est en tout cas le chemin que semble emprunter une bonne partie de l'industrie. Outre OpenAI, Google prépare une fonctionnalité similaire. Thomas Wolfe, co-fondateur de la startup franco-américaine Hugging Face, estime quant à lui que la technologie vocale interactive sera partout. « Ce sera bientôt un service de base », dit-il dans une publication X, félicitant Kyutai.

Mais à quoi bon s'entêter à nous faire discuter avec des IA ? Kyutai justifie ce choix en expliquant que cela reste le meilleur moyen de se faire comprendre pleinement par une machine.

« On utilise le texte depuis quelque temps, mais cela ne permet pas tout. Pour avoir une conversation spontanée, la façon dont on dit les choses est aussi importante que le contenu. Avoir une dynamique de conversation est très difficile à obtenir en texte », explique Neil Zeghidour, ex-chercheur de Google DeepMind et co-fondateur de Kyutai.

Une technologie compacte

L'autre prouesse du jeune laboratoire est d'avoir mis au point une intelligence artificielle générative compacte, notamment grâce à une technologie de compression audio. Moshi, est capable de tourner sur un Macbook Pro, assure les chercheurs. Et bientôt sur un simple smartphone.

Le laboratoire innove également dans sa manière d'acquérir des données d'entraînements. « Pour apprendre à une IA à parler, il faut des données conversationnelles audio et c'est très difficile à trouver », explique Edouard Grave, ancien d'Apple et Meta et désormais chercheur chez Kyutai. Moshi a appris via la base de données Fisher (où l'on trouve des heures d'enregistrements de conversations téléphoniques des années 1990 et 2000), mais aussi grâce à des dialogues « synthétiques ». « Nous avons demandé à notre grand modèle de langage Helium de générer des dialogues qui ressemblent à une transcription de conversation, puis utiliser ces dialogues ont été transformé en fichier audio grâce à un modèle "text to speech" (du texte à la voix) », et Moshi a été entraîné sur ces productions.

Helium, qui sert donc de base à Moshi, est un modèle relativement léger, de 7 milliards de paramètres, soit l'équivalent des petits modèles de Mistral AI ou de Meta.

Garder l'esprit laboratoire

Par ailleurs, Moshi comme les autres technologies qui l'accompagnent seront accessibles en open source d'ici à la fin de l'année. Et c'est là aussi où le laboratoire français se distingue le plus de son grand frère américain qui ne conserve d'"open" que le nom.

Contrairement à OpenAI, qui a abandonné sa structure de fondation à but non lucratif, pour devenir en 2019 une entreprise à but lucratif plafonnée et bientôt à profit illimité selon The Information, les équipes de Kyutai insistent sur le fait que de développer un produit n'est pas leur but. « C'est aux startups et entreprises qui s'empareront de Moshi (dont le modèle de licence exact est à définir, Ndlr) de trouver des cas d'usages », explique Patrick Pérez.

Eumetsat : l'Allemagne met KO la France en imposant SpaceX au détriment d'Ariane 6

Eumetsat : l'Allemagne met KO la France en imposant SpaceX au détriment d'Ariane 6

Sujets les + commentés