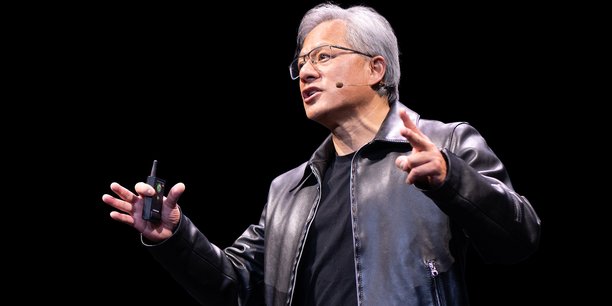

L'annonce a été quelque peu éclipsée : elle n'a pourtant rien d'anodin. En mars dernier, alors qu'il annonçait sa nouvelle génération de microprocesseurs Blackwell, surpuissants et taillés pour l'entraînement de modèles d'IA de pointe, le dirigeant de Nvidia, Jensen Huang, évoquait également l'ajout d'un nouveau service à sa suite logicielle.

Baptisé NIM, pour Nvidia Inference Microservice, il vise à aider les entreprises à tirer le maximum de leurs GPUs Nvidia issues des générations précédentes pour utiliser l'intelligence artificielle (IA) au quotidien.

Qu'est-ce que l'inférence ?

Dans le monde de l'IA, l'inférence correspond au processus qu'un modèle d'apprentissage automatique déjà entraîné utilise pour tirer des conclusions à partir de nouvelles données. Il s'agit en somme, pour une entreprise, de faire tourner un algorithme d'IA pour répondre à des cas d'usage concrets. L'inférence fait suite à l'entraînement, le processus qui consiste à nourrir un modèle d'immenses quantités de données jusqu'à ce qu'il parvienne à accomplir une tâche spécifique. OpenAI a par exemple dû longuement entraîner ChatGPT avant de le faire découvrir au grand public.

Mais lorsqu'une entreprise utilise ChatGPT pour construire un chatbot chargé de faire du service client, elle n'a pas besoin de réentraîner le modèle. Elle va simplement recalibrer celui-ci pour qu'il fonctionne sur un socle de données plus restreint, celui de l'entreprise, et le faire tourner pour répondre aux questions des clients. Presque toutes les applications de l'IA dans le monde réel s'appuient donc sur l'inférence.

Comme l'écrit Mike Demler, analyste indépendant spécialisé dans l'industrie des puces informatiques, l'entraînement sans l'inférence « serait comme construire une voiture de course que personne ne conduit jamais. » Là où l'entraînement requiert des puces informatiques très puissantes hébergées dans des centres de données, l'inférence peut se faire via des puces moins chères (quoique toujours très complexes) et dans l'informatique en périphérie.

Pourquoi l'inférence est dans tous les esprits

Entraîner un modèle d'IA générative comme celui d'OpenAI, de Google ou d'Anthropic AI, dits « modèles de fondation », requiert des moyens considérables, estimés à plusieurs centaines de millions, voire à plus d'un milliard d'euros. Le processus est en effet gourmand en puissance de calcul, requiert d'importantes dépenses énergétiques et un grand nombre de microprocesseurs de pointe. Pour concevoir le modèle de langage qui alimente ChatGPT, plus de 10 000 cartes graphiques A100 de Nvidia ont ainsi dû être utilisées par OpenAI.

En plus d'être très chères (une seule puce de la dernière génération Blackwell se monnaie entre 30 000 et 40 000 dollars), celles-ci sont soumises à une très forte demande. Lorsque Blackwell est sorti en mars, il fallait encore plusieurs mois d'attente pour espérer mettre la main sur une puce de la génération précédente, Hopper. Enfin, entraîner un modèle de fondation peut demander plusieurs mois de travail. La conséquence de tout cela est que peu d'entreprises vont à l'avenir entraîner leur propre modèle de fondation, et que la plupart vont piocher parmi les modèles déjà existants et se contenter de faire de l'inférence.

Avec des conséquences importantes sur le marché des processeurs informatiques. Certes, « pour l'heure, la bataille se concentre sur les puces les plus puissantes, capables d'entraîner les modèles d'IA », affirme Christophe Duverne, associé et cofondateur de Silian Partners, premier fonds d'investissement européen spécialisé dans les puces informatiques. Mais les choses sont en train de changer.

Colette Kress, directrice financière de Nvidia, a ainsi récemment annoncé que l'inférence a compté pour 40 % des ventes de la division « centres de données » de la société, qui comprend notamment les puces puissantes dédiées à l'IA. La plupart des experts estiment que cette part ne va faire que s'accroître.

Vers des puces spécialisées dans l'inférence

Pour cette raison, les fabricants de puce informatique se positionnent les uns après les autres sur ce secteur stratégique de croissance. « Vu les coûts d'entraînement des modèles de fondation, il va y avoir une segmentation du marché, avec certaines entreprises plutôt spécialisées sur l'inférence », note Christophe Duverne. Certains, comme Intel, parient sur des puces plus simples et moins chères à destination des entreprises cherchant à utiliser l'IA pour un coût raisonnable.

« Je ne vais pas recourir à des puces H100 (NDLR un modèle de GPU de Nvidia) qui coûtent 40 000 dollars pièce, consomment trop d'énergie, demandent de nouveaux modèles de managements et de sécurité et une nouvelle infrastructure IT si je peux faire tourner ces modèles sur des puces standardes », déclarait ainsi Pat Gelsinger, patron d'Intel, dans une interview en décembre dernier. « Nous allons faire beaucoup d'inférence sur nos CPUs. » Un tiers des CPUs vendues par Intel sont aujourd'hui destinées à faire tourner des charges de travail d'IA, selon le dirigeant.

D'autres misent sur des puces taillées spécifiquement pour l'inférence. « Les puces spécialisées dans l'inférence peuvent être taillées sur-mesure pour des charges de travail bien spécifiques. Des architectures, comme les Tensors Processing Units (TPUs) de Google ou les Neural Engines d'Apple, sont optimisées pour effectuer des opérations avec des réseaux de neurones. En éliminant les composants non nécessaires, ces puces réduisent les coûts », note Doug Hogue, consultant spécialisé dans les nouvelles technologies.

En plus des Gafam, plusieurs start-up s'efforcent également de se faire un nom sur ce nouveau marché, à l'instar de Groq, jeune pousse fondée par un ancien ingénieur spécialisé dans les puces d'IA chez Google. Une récente démonstration durant laquelle l'entreprise a exposé à quelle vitesse ses puces d'inférence pouvaient générer des réponses à partir d'un LLM a fait couler beaucoup d'encre. L'entreprise ambitionne de déployer jusqu'à 1,5 million de puces l'an prochain. Cerebras, une autre jeune pousse de la Silicon Valley, partenaire de Qualcomm, a déjà engendré des centaines de millions de dollars en se positionnant sur ce créneau. La start-up Recogni a de son côté récemment levé plus de 100 millions de dollars pour sa puce d'inférence. On compte par ailleurs des jeunes pousses françaises comme Vsora, en train de lever des fonds.

Nvidia, qui s'est déjà imposé comme leader incontesté sur les puces d'entraînement de l'IA, avec plus de 80 % de part de marché, est également très bien positionné pour remporter une large part du gâteau de l'inférence. Celui-ci s'annonce toutefois si vaste qu'il est moins probable qu'il soit dominé par un seul acteur, selon Mike Demler. « L'inférence est un marché beaucoup plus gros, qui va des capteurs intelligents alimentés par des batteries aux serveurs. Je me suis penché sur plus de 50 sociétés spécialisées dans les puces d'inférence, dont seulement quelques-unes s'attaquent à la domination de Nvidia. »

Une opportunité pour l'Europe

Le passage à l'inférence représente aussi une opportunité pour l'Europe, qui compte des centres de recherche de classe mondiale dans les semi-conducteurs (dont le CEA Leti à Grenoble, Imec en Belgique et l'institut Fraunhofer en Allemagne), un champion mondial dans les équipements (ASML) et des entreprises compétitives comme STMicroelectronics et Bosch. Mais aussi un écosystème de plus petits acteurs susceptibles de bénéficier des retombées de l'IA.

« Dans le domaine des matériaux ou de l'équipement, l'Europe compte de nombreux acteurs porteurs d'innovations qui vont permettre aux fondeurs que sont TSMC, Samsung et Intel de trouver des solutions nouvelles pour produire les puces qui permettront de faire tourner les modèles d'IA », note Christophe Duverne.

Silian Partners, premier fonds européen d'investissement spécialisé dans les puces informatiques, a été lancé à l'automne 2023 afin d'investir dans les jeunes pousses des semi-conducteurs et est en train de compléter sa levée de fonds.

« Le thème de l'IA est un sujet majeur pour l'industrie des puces informatiques. Selon McKinsey, le marché de l'IA devrait constituer 20 % du marché des puces d'ici à 2025, ce qui devrait représenter autour de 150 milliards de dollars. Mais cela constitue aussi un défi très complexe : il faut arriver à faire rentrer une puissance de calcul énorme dans un espace très réduit, avec le moins de consommation énergétique possible. Cela implique de revoir les puces, mais aussi les algorithmes... Tout cela crée beaucoup de défis, de concurrence et des opportunités gigantesques », conclut Christophe Duverne.

En France, le grand décrochage des prix de l’électricité

En France, le grand décrochage des prix de l’électricité

Sujets les + commentés